AI信仰决定了一个公司愿不愿意全身心All in AI。就像攀岩一样,如果你不相信你的双脚,不相信安全绳,就攀不了岩。

作者|甲小姐 刘杨楠

编辑|王博

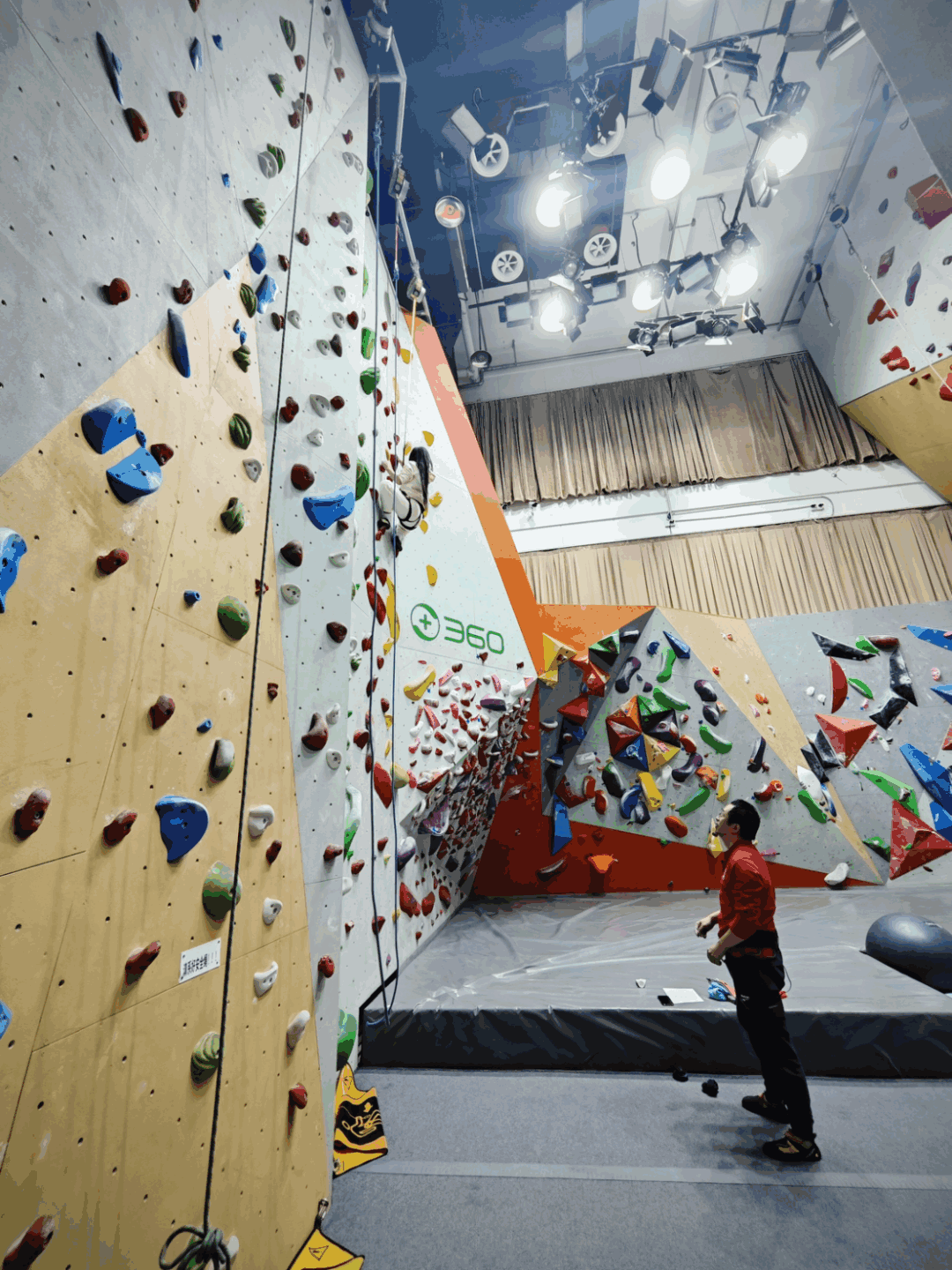

“我们在攀岩馆聊吧。”

53岁的360集团创始人周鸿祎过往在公众面前有很多标签,如今又多了一个——攀岩爱好者。去年,他直接把攀岩馆建在了360集团总部大楼里。

这可能是历次甲小姐对话中,地点最特殊的一次。

谈及为何学攀岩,这位“红衣大叔”的回答很朴素——第一,增加一项求生技能,要是某天发生灾难,会攀岩的人在废墟中的幸存率更高一点;第二,增加核心力量;第三,增加平衡感。

这座攀岩馆已经留下很多企业家的身影,包括王石、俞敏洪等。2023年12月13日,在北京的雪夜中,这里终于迎来第一位女性创业者——甲子光年创始人&CEO张一甲。

周鸿祎指导甲小姐攀岩,图片来源:「甲子光年」拍摄

攀岩只是预热,这次对话的主题还是AI。此前,在2023甲子引力年终盛典的巅峰论坛上,周鸿祎有过精彩的分享,其中“美国已经在全力以赴开动下一场工业革命”的表述还上了微博热搜。继续未完的话题,于是有了这次“雪夜岩馆之约”。

从岩壁上下来,周鸿祎对甲小姐说:“AI信仰决定了一个公司愿不愿意全身心地去All in AI。就像攀岩一样,如果你不相信你的双脚,不相信安全绳,就攀不了岩。”

站在现在时间的横截面上,很多人对AI的发展感到“乱花渐欲迷人眼”,有太多新闻,太多观点,反而很难获得真相和答案。但周鸿祎对AI已经产生了笃定的体系感。

建立Al信仰,All in AI,不断提高自身含AI量,是周鸿祎提出的“AI三角”。

周鸿祎有两个“坚定”:一方面,他是坚定的AI发展派,认为未来3-5年,人工智能会引发一场全新的工业革命,不应该为了安全风险因噎废食;另一方面,作为多年的安全专家,他又坚定地发展AI安全,要将大模型“关进笼子里”。

本文,甲小姐对话周鸿祎,聊聊AI信仰,以及与之相关的一切。

甲小姐对话周鸿祎直播现场,图片来源:「甲子光年」拍摄

1.谈派系:“坚定的发展派”

甲小姐:上次论坛最后,我们聊到“AI的派系之争”。上个月OpenAI的权斗事件,让硅谷人工智能领域的两个派系“浮出水面”——一派叫e/acc,有效加速主义,比较激进地认为人类应该无条件地加速技术创新,技术爆发一定对人类有好处。OpenAI创始人萨姆·奥尔特曼(Sam Altman)就很像这一派;另一派叫EA,有效利他主义,认为要尽可能保证AI对人类是有爱的,不能伤害到人类,当AI可能威胁人类,就应该加以阻止。OpenAI首席科学家伊利亚·苏茨克维(Ilya Sutskever)的立场就很像这一派。当时,你说这个分类不够好,自己是“坚定的发展派”。如果让你给国内人工智能领域划分一下派系,你怎么分?

周鸿祎:首先我比较反对用美国人编的那两个名词,什么e/acc、EA,说一会儿我就晕了。中国可能就三派,一派是坚定的发展派,坚定发展人工智能;一派是抵抗派,他们觉得人工智能最终也许会超越人类,所以保持很高的警惕;还有一派是无所谓派。

甲小姐:你说自己是“坚定的发展派”,这种“坚定”从何而来?

周鸿祎:现在人类自身的进化已经基本停止了,几十万年来我们的个子变高了一点,大脑也没有变化太多。人类只能靠不断发明各种有力的工具来突破自己的边界——人不会飞,但人类发明了飞机;人不能在海底生存,但人类发明了潜水艇。

在人工智能方面,人类经过60年的努力,终于取得“零的突破”。过去一年我们“度日如年”,一方面大家都有压力,觉得如果自己不搭上这班车可能会被淘汰,特别是搞互联网、数字化的人离人工智能更近一点,感到的压力更大;另一方面,这轮人工智能发展的速度极快,在AI生成图片、视频方面每天都有论文出来,一天取得的成果相当于大模型突破前一年的进度。

我认为人工智能是人类有史以来比电脑、互联网还要牛的真正强有力的工具。这个工具可以给人类带来工业革命级的变化,会重塑社会各个行业,包括人们生活、工作的方式。人工智能是一个巨大的发展机会,不要因为今天还不存在的问题就拖慢了发展节奏,所以我是坚定的发展派。

甲小姐:你身边的企业家都是什么派?

周鸿祎:我遇到的大多是发展派。企业家的使命就是在困难中看到机会。如果天天抱怨,但拿不出解决方案,这不叫企业家。

甲小姐:担忧AI发展的人,有一个很朴实的想法,历史上从来没有一种低级生物可以控制得住一个智能水平更高的生物。当AGI到来,人类如何例外?

周鸿祎:这个问题把我问住了。但其实这是个“伪命题”。我认为今天很多人对“碳基生物”“硅基生物”的划分很不科学。大模型是一种技术,和数字化技术一样,它会以各种形态存在于社会中,和人类共生。大模型不一定全在一个阵营,可能会有被用来做坏事的大模型,我们肯定也能造出对人类友好的大模型,帮人类来对抗作恶的模型。

甲小姐:所以你认为无论AI多么强大,人类依然能控制AI?

周鸿祎:这是我们追求的目标。曾经有一个科幻故事,一个器皿里漂浮着一个用福尔马林浸泡的大脑,它只能跟人交流,它只有真正长出手和脚,或附身到机器人上,拥有在现实生活中调用API的能力,才可能伤害人类。这些能力不是它与生俱来的,是人赋予它的。人能赋予它能力,就能控制它。

甲小姐:上次你聊到,“大模型什么都好,最致命的问题是能源问题。如果全球都建超大规模的大数据中心,有可能全球的能源根本就不够用,不用担心硅基生物超越碳基生物那一天。”这种能源困境有解决的思路吗?

周鸿祎:今天的人类文明快要碰上一个瓶颈了。人类在牛顿、爱因斯坦时代,以及杨振宁、李振道时代都有很多璀璨的群星,出现了很多物理学家、化学家、数学家。但最近100年人类很多科学成就都是应用科学,基础理论缺乏突破,这导致人类很难走向星辰大海。

马斯克的想法很好,但用化石能源也就只能送点东西上火星,要走出太阳系几乎都不可能,更不要说星际旅行。今天新能源说得很漂亮,但都是碳基能源生产的,如果再过50年地球上没有煤也没有石油,新能源能否实现自我循环可能都不一定。没有室温超导、可控核聚变这些物理、化学上的突破,完全是不行的。

今天的大模型只会跟你聊天,帮你写文章,但这只是大模型最初的基本能力。将来,大模型还有一个很重要的能力,就是成为科学家的工具,帮助人类突破科学问题。

2.谈安全:“要真正把大模型放在笼子里”

甲小姐:对AI发展激进或保守态度背后的本质争议是,我们能不能让AI在更强大的同时又足够安全。360是做安全业务起家的,你相信人类最终能够控制强人工智能,是因为你比其他AI从业者更懂安全吗?

周鸿祎:这话只能对一半。做安全的人往往是悲观主义者。一般人看到一个新事物都会先拥抱它,但我们做安全的人会先琢磨它有没有什么不安全的地方,而不是稀里糊涂地把它当成一个黑盒子。

从安全的角度出发,我很有信心让防御攻击的安全技术越来越高明。

很早以前在安全领域有一个全球性难题,就是零日漏洞(zero-day),这种漏洞可以神不知鬼不觉地深入你的系统,在你的系统里潜伏多年,慢慢移动到你的核心电脑上窃取或破坏资料。我们用10年时间破解了这个难题。我们原来是看不见这种国际级攻击的,但现在我们都能发现、追踪、定位并把它踢出去。所以我们在安全技术方面还是有很多积累。

甲小姐:你在计算机安全中积累的经验可以在人工智能领域复用吗?

周鸿祎:人工智能本质是一种软件,只是人工智能的安全问题比较复杂,可以分为三层——

第一层是数据安全。数据质量直接决定了大模型的能力。换句话说,你的数据被污染了,用坏数据训练出的大模型在某些时候就会出错。这种数据污染攻击在技术层面都好解决,还是在传统的数字化范畴里;

第二层是内容安全。大模型不可能只学好知识,它不可避免会学很多坏知识。比如现在用大模型做欺诈、做网络攻击的难度特别低。很多人试图在大模型里建立安全围栏,让它不能教人做炸弹、做毒品。但很多人能通过一种“注入攻击”或“算法攻击”的方式,通过花言巧语的诱导,让大模型变得很傻很天真,对人无话不说;

第三层,也是最大的安全问题,大模型有杜撰能力,其实这不是缺点,恰恰证明了大模型拥有智能,有智能的东西才会杜撰。搜索没有智能,所以搜索不会告诉你不存在的东西。大模型不一样,当你问它一个不存在的东西时,它会用一些它知道的知识给你瞎编一个,这是一种创造力的体现。但有些场合,比如在企业或工业内部,这种杜撰可能就变成一种危害。如何保证大模型在某些场景下生成的内容准确无误,是整个内容安全的核心,这里面可能需要很多新技术。

今天的大模型还不太会用工具,也无法附身到很多机器人、无人机上,还没有真正和世界连接在一起,不能亲自感知世界,但未来一旦出现这种情况,如何有效监控大模型的行为是否得当就很重要,要把大模型放在笼子里。

甲小姐:你多次提到,可以训练一个GPT来监督另一个GPT,为什么大模型无法自我监督?

周鸿祎:一个复杂系统无法对抗自己的系统弱点。大脑就是复杂系统,人的大脑皮层有各种脑区,包括语言区、视觉区、早期动物本能的核心反应区,人类还产生了独有的推理、运动区域。大模型也是一个复杂系统,GPT背后有16个专家模型组成,它很难自我修正,需要通过系统外部的力量来约束它。但我们可以训练一些小规模的大模型,比如,有的大模型负责检测用户对大模型的注入攻击;有的负责检测内容安全。这些小模型功能单一,不会危害人类。

甲小姐:训练一个GPT来监督另一个GPT,360目前进展如何?

周鸿祎:我们在研究AI安全时发现,Agent架构是设计安全最好的方式。按照360的思路,我们有很多探针、传感器,实时把大模型每天的行为收集起来,专门给另一个大模型做分析、研判,一旦发现问题,另外一个大模型就会及时叫停这个大模型。当然这不涉及用户行为和数据。这个负责监督的大模型就只做一件事,不需要和外界打交道,只听我们的指令,能力很单一,所以它不太会对世界造成危害。

甲小姐:为什么说“Agent是设计安全最好的方式”?

周鸿祎:我认为Agent是人工智能领域一座很重要的里程碑。Agent是从一个叫Longchain的开源项目中诞生的。这也是我认为开源很了不起的原因,GPT出现后开源社区围绕它做了很多探索。

大模型只是一个大脑,它没有工具。一个人离了工具啥也做不成,大模型也一样。现在大模型很被动,没有目标,做一件事需要你和它对话多次,形成一个workflow(工作流)。

而我们在真实工作中,需要一个智能超人,我给它设定一个目标,他就能按这个目标完成任务。每完成一轮任务,我们还要有一个奖励函数,这些都是大模型不具备的能力,而现在这些能力都能够被放在Agent的框架里。在大模型产生意识前,Agent能够让大模型真正的威力发挥出来。

GPTs就是OpenAI做的一个简单的Agent架构,简单到一个人用自然语言就能定义。如果定义复杂了, 用的人就少。因此GPTs的能力比GPT要强大,它知道什么场景下要完成什么任务,可以调取独特的数据和API。如果要做行业模型,没有Agent架构,基本上是不可想象的。

3.谈发展:“不发展才是最大的不安全”

甲小姐:智能,意味着强大,安全,意味着听话,从定位上,安全对智能有一定的制约作用,二者似乎有着相反的作用力——做智能就像在做发动机,做安全就像在做刹车系统。二者在你看来矛盾吗?

周鸿祎:不发展才是最大的不安全。做安全的理念是,不安全的情况不可避免,它出现的时候我们如何把危害减到最小。

今天汽车的安全已经不是靠刹车了,很多时候你来不及刹车,也有人会踩错刹车。安全靠安全带、安全座椅、安全气囊、发动机舱等环节的设计。同样,我们要解决数据安全问题并不需要降低数据传输速度,解决网络安全问题并不需要切断所有网络。

人工智能越能干对人类的帮助越大,我们要做的是,一旦人工智能出现伤害人类的情况,我们有一种关键装置能及时制止它。

甲小姐:在你看来安全和智能是正相关的?

周鸿祎:我们不能为了发展而不顾安全,也不能为了安全而停止发展。安全的目的不是为了制约,是为了让大家更放心地使用人工智能。当然,也许我们的解决答案不完美,因为“道高一尺,魔高一丈”,大家都在进化。自然界中每个生物都有天敌,人类的天敌可能是细菌、真菌、病毒这些微生物,可能比人工智能更可怕。很多人听我讲了安全之后,反而对人工智能更有信心了。

甲小姐:上次你在甲子引力说,我们这辈子大概率看不到硅基生命取代碳基生命了。

周鸿祎:人类打核战自我毁灭的概率可能更大一些。

甲小姐:安全和发展之间是否会存在一条边界,越过这条边界后,人工智能不安全的几率会陡增?

周鸿祎:有一个原则,我认为现阶段,在一些关键的场景下,人类要在人工智能的决策回路里。美国有一家公司自我吹嘘说人工智能可以直接接管美军无人机。现在我们还没有真正把人工智能关进笼子里,它能够自主决定的后果很可怕。

这也是360做大模型一个很重要的原因——我们立志要解决大模型的安全问题,但如果我不了解大模型,我根本没有办法解决大模型的安全问题。人类通过什么样的技术手段让人工智能保持安全,这是未来几年我们面临的一个很大的问题。即使将来有一天,大模型变成一个超级物种,人类作为它的创造者,我也依然相信人类还是万物之灵。

甲小姐:上个月你去了一趟硅谷,后来你在社交网络以及甲子引力上都分享了一些见闻。这次去硅谷最让你意外的发现是什么?

周鸿祎:美国有很多偏激的言论,让别人觉得他们人人都很担心人工智能安全问题。但事实上,美国整个产业界完全在拥抱大模型,拥抱人工智能——VC非AI项目不投,创业者会想方设法在自己的项目里加入人工智能,包括美国财富500强的大公司都在思考如何用AI加持自身业务。

另外,美国人也在抢英伟达的GPU,而且GPU在美国卖得也很贵,你有钱也买不到货。很多创业公司开玩笑说融到钱也没用,钱也不能训练大模型,谁能给我投英伟达显卡或者借给我用,我就愿意接受谁的投资。马斯克也是嘴上说一回事,行动是一回事。他一直在喊AI很危险,但自己偷偷买了几万张卡,建了个团队。

所有人都明白,如果不用AI改造、赋能你的业务基因,你就会被同行降维打击。所以AI不会淘汰人,不会淘汰公司,而是会用AI的公司会把其他人淘汰。

甲小姐:美国哪些做法或思想是中国可以借鉴的?

周鸿祎:我上次去美国问他们美国如何解决社会问题和经济问题,他们的答案是——必须创新,必须抓住这次工业革命的机会。他们认为这次人工智能带来的工业革命不亚于95年的互联网或80年的PC。如果通过这个机会创造一个增量市场,就有可能在发展中解决很多已经存在的问题。否则一直在存量市场里竞争,可能很多矛盾难以解决。

我并不崇洋媚外,但我们得承认,美国在人工智能方面还是比我们领先,我们要学习他们的一些做事方法。人工智能是属于全人类的技术,我们如果能把人工智能发展起来,对中国的帮助也很大。他山之石,可以攻玉。我们要知道世界上其他人都在干什么。

4.谈格局:“极大限度降低推理成本后,真正的人工智能革命就来了”

甲小姐:你在微博上谈“从长期看谷歌赶上GPT-4绰绰有余”,为什么你判断谷歌能追上OpenAI?

周鸿祎:通用大模型发展到今天,人才密度、算力密度和数据质量的高低已经成为决定胜负的关键。

谷歌之前没有发力有三个原因——

首先,公司做大了难免目标不统一,发明Transformer之后大家都满足于在此之上写个论文,而不在乎把算法从论文变成产品从而改变世界。谷歌不让人家发论文,这些人就走了。

第二,对于谷歌而言,若要成功,必先自宫。谷歌原先主要的业务收入来自搜索,如果做好大模型,就可能颠覆搜索。谷歌做大模型首先打的不是OpenAI,而是自己。为什么微软毫不犹豫推出New Bing?因为Bing在搜索市场的占有率可以忽略不计,他光脚的不怕穿鞋的,怎么玩儿都行;

最后,美国的舆论环境是,对大公司吹毛求疵,对创业者基本完全包容。小公司说一些破格的话,做错事,大家觉得是敢想敢为、有创造力;但大公司做错一点事都会导致公众口诛笔伐,这时候公司的法务、公关部都会站出来。这些人都不会保障公司的创造性,而是保证公司不犯错,相当于谷歌是在戴着镣铐跳舞。

所以在谷歌把这三个问题想明白后,就取得了很好的进展。首先算法上,Transformer就是谷歌原创的,不是问题;第二,谷歌本身就是做搜索的公司,还有YouTube等那么多产品,数据也不是问题;第三,据说谷歌这次做Gemini聚集了七八百人,人数已经不比OpenAI少了,人力也不是问题。长期来看,谷歌还是最有钱、最有人才。所以谷歌一旦想通了,把自己的团队整合、打通技术,充分利用自己的资源,最终效果肯定很好。

甲小姐:谷歌这次的进展,会如何影响全球AI的路线选择和产业格局?

周鸿祎:第一,大模型下一步竞争可能不再是文本知识,而是多媒体数据。Meta最近也精神抖擞,基于其Emu图像生成模型,发布了一个免费的独立AI图像生成器网站“Imagine with Meta AI”。Imagine比Midjourney、Stable diffusion还要好,因为Meta有两大软件——Facebook和Instagram。Instagram是全世界最大的图片社交分享网站,数据量大了,出图效果自然就好。现在国内多模态比国外弱一些。

第二,当手机上的传感器都跟大模型整合为一体,会产生非常多的应用场景。谷歌这次推出Nano版本,能在终端、手机等各种设备上部署模型,这样大家就不用学OpenAI的路。OpenAI恨不得在全世界垄断,独此一家别无分号,大家都用他的云端服务。

不要忘了,全世界的安卓系统都是谷歌的。今天的OpenAI在手机上还只是一个App,没有和手机系统打通。而谷歌推出Nano版本后,可以把自己的Gemini Nano或者Gemini Pro在云端或本地部署,跟安卓系统紧密连在一起。

第三,谷歌还有一个杀手锏——TPU。谷歌没有用英伟达的GPU训练,因为英伟达的东西确实很贵。当然,谷歌也买得起。今天训练成本只是贵一时,因为你不会天天训练,训练三周、一个月也就差不多了。最大的成本是推理成本。

我认为推理成本是妨碍人工智能普及的一个重要因素。今天搜索成本非常低,几乎为零,所以搜索可以免费让一亿人用都没问题,流量大了之后就有广告,这是比较成立的模式。但OpenAI为什么不敢让人免费用,只能使用一段时间?因为你用得越多,用他的算力就越多,推理成本很高,他一个月就就要收你几十美元。

如果推理成本降不下来,谷歌的“免费+广告”模式就推动不下去。但是谷歌用 TPU之后,如果它的推理成本能比英伟达的GPU降低100倍,那么谷歌就有可能针对高级用户收费,对普通用户免费,广告模式就能得以延续。这样就把谷歌最纠结的问题解决了。

我听说微软也在搞芯片,OpenAI、Facebook、苹果等等所有的公司都在搞芯片。我也了解了一下,大家不是要跟英伟达直接竞争,而是大家都要解决推理芯片的问题,目标就是两件事——第一,让大模型能够部署到边缘终端、PC服务器、手机,包括汽车智能设备上;第二就是极大限度降低推理成本。

我认为明年这个问题解决后,真正的人工智能革命就来了。大家几乎可以免费使用大模型,这对各行各业的赋能是完全不同的,会快速改变整个世界。

甲小姐:有人认为大模型是新一代操作系统,你怎么看?

周鸿祎:事实上我一直觉得大模型未来更像PC,而不是操作系统,大模型会无处不在。

对企业而言,以大模型上车为例,分三个阶段——第一步,先用云端把大模型接到车上,在车里变成一个个人助理,可以和你聊天、活跃气氛,我认为这是最粗浅的应用;第二步,通过API和汽车本地的智能座舱结合在一起,能够控制车上的娱乐车门锁闭、天窗开启;第三步,如果大模型真的和自动驾驶结合在一起,光靠云端算力就不够了,大模型就要部署到本地。

很多创业公司一旦悟了这点,我认为最终就会分为三支队伍——第一,继续依托已有大模型的API找场景,做应用,这个市场依然很大;第二,和各种设备结合,尤其是边缘和终端设备;第三,是在企业级、产业级大模型上做私有化、本地化部署和深度定制。

5.谈信仰:“AI信仰决定了一个公司愿不愿意全身心地去All in AI”

甲小姐:最近你有一个新观点,提倡企业建立“AI信仰”,即相信AI是真AI、相信AI是工业革命级技术、相信AI将重塑所有业务、相信不拥抱AI的公司和个人都将被淘汰。“信仰”是一个比较抽象的词,你如何判断企业是否有“AI信仰”?

周鸿祎:这本来是我对内部的讲话。因为我在内部天天说人工智能,但我发现有些团队转型了,有些还没有,所以我提出AI信仰的概念。我认为每个公司、每个团队都要衡量他们有没有AI信仰,就是你到底信不信AI——现在很多人还不信。我们要相信,这一次是真正的人工智能,不是人工智障,跟我们原来搞的那种假的人工智能有本质不同。AI信仰决定了一个公司愿不愿意全身心All in AI。就像攀岩一样,如果你不相信你的双脚,不相信安全绳,就攀不了岩。

甲小姐:建立AI信仰之后,企业如何“All in AI”?

周鸿祎:对内,要找到一些能被人工智能改造的业务流程。你不改造,你的同行一定有人改造,就像人家手里有AK-47,你还是拿了大刀长矛,这就是生产力工具的差异。

对外,首先你要看一看所有产品中有哪些能被AI加持,不能被AI加持的产品就应该被淘汰。在能保证数据不泄露的情况下,大家一定要多用大模型。如果你们公司的人都不用AI,将来你说要转型AI,那真的是缘木求鱼。

第二,公司关键的技术人员、产品经理要看很多最先进的AI论文,研究很多AI产品,再来看自己的产品进展。AI说神秘也不神秘,就是看这些AI先锋都在做什么,看微软在做什么,Salesforce在做什么,谷歌在做什么,包括ChatGPT推的产品,Stable diffusion推的产品都要去看。

第三,公司All in AI不在于你买了多少块显卡,也不在于你投的钱比百度多,要量入为出,在非常细微的环境都用到AI,比如面试、财务、做内容这些方面。All in AI并不是说你要做一个AI原生的Killer App,哪怕你只是把所有业务都加上AI,也算是All in AI。

甲小姐:你还提到,“在拥抱AI的过程中,企业要以‘含AI量’作为企业拥抱AI的衡量标准,维度包括员工熟悉AI的程度,产品及业务流程被AI加持的程度等。目前,360内部已经以此为标准进行全流程改造。”企业的“含AI量”怎么计算?

周鸿祎:那就是看我们有多少人每天都在用AI,在谈论AI,在熟悉AI,还有我们有多少产品都加了AI。整体来看,AI信仰、All in AI、含AI量这三个概念是一个三角形。首先要有AI信仰,然后All in AI,不断用自己的含AI量来恒量自己的AI信仰是否坚定。

越是传统的企业,越要想办法要建立AI信仰。用AI的过程中你就会发现,原来你的数字化程度还不够高,用AI就会倒逼你加快数字化,因为你有数据、有知识,才能训出自己的大模型。 我相信在未来3-5年,人工智能会引发一场全新的工业革命。

对此,我有两个观点——第一,发展AI要有长期主义。这件事不会热一阵就过去了,而是会长期改变我们每个人的生产生活。第二,做企业的人要有企业家精神,坚持创新。我希望所有公司和个人都能借助这波AI的机会,自我重塑。

*RAM对本文亦有贡献

24104

24104 1

1 0

0 0

0